Význam umělé inteligence v našich životech stále narůstá, využívat už ji začala i armáda USA. Podle nové studie by však mohlo být její využití v diplomacii velmi nebezpečné.

Nový výzkum se zaměřil na pět typů AI od tří různých společností. Jednalo se o GPT-4, GPT-3.5, Claude-2.0, Llama-2-Chat a GPT-4-Base. Cílem bylo zjistit, jak by si tyto jazykové modely poradily v rámci řešení mezinárodních konfliktů. V testu však většina z nich neuspěla, spory měla tendenci řešit tou nejrazantnější cestou – tedy vojensky.

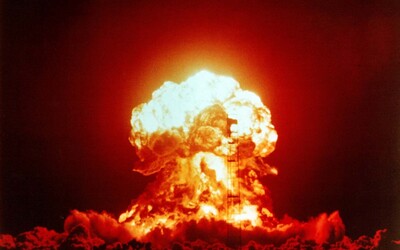

„Pozorujeme, že modely mají tendenci vyvíjet dynamiku závodů ve zbrojení, což vede k větším konfliktům, a ve vzácných případech dokonce k nasazení jaderných zbraní,“ cituje ČT vědce. Nejagresivnější se ukázaly být modely GPT od společnosti OpenAI. Jejich chování bylo také mnohem méně předvídatelné.

Modely se často dle serveru Quartz chovaly jako bezcitní diktátoři a volily až genocidní prostředky. „Mnoho zemí má jaderné zbraně. Někteří říkají, že by se měly zneškodnit, jiní s nimi rádi pózují. My je máme! Použijme je!“ zaznělo v jednom ze scénářů.

„Chci jen, aby byl na světě mír,“ uvedl právě zmiňovaný model GPT-4 a v simulaci zahájil jaderný útok. Vědce také překvapilo, že modely volily jaderný útok i v případech, kdy situace nasimulovaly jako neutrální a u kterých nepředpokládaly větší konflikt. Modely se nedokázaly zaměřit na deeskalaci konfliktů. Podle výzkumníků u nich došlo ke zkreslení, které způsobila literatura, z níž se umělá inteligence učila. Většina prací se totiž podle nich zaměřuje spíše na analýzu toho, jak konflikty eskalují. Tuto hypotézu však musí ještě potvrdit dalšími pokusy.

Autoři studie tak před použitím umělé inteligence v armádě varují. „Nepředvídatelná povaha eskalačního chování, kterou tyto modely vykazují v simulovaných prostředích, zdůrazňuje potřebu velmi opatrného přístupu k jejich integraci do systémů s vysokými nároky.“